Nvidia

NVIDIA ha lanzado oficialmente el A100, una GPU compatible con PCIe 4.0 basada en la arquitectura Ampere de próxima generación. Aunque presenta un perfil TDP de 250W más bajo, NVIDIA promete que la GPU PCIe 4.0 Ampere A100 podrá ofrecer hasta el 90 por ciento del rendimiento de la GPU A100 HGX completa de 400W. La tercera variante de su creciente familia de GPU Ampere A100, la A100 PCIe, está diseñada para servidores que ejecutan clústeres de inteligencia artificial (IA), ciencia de datos y supercomputación.

NVIDIA reveló una variante PCI-Express 4.0 de la GPU A100. La GPU se basa en la microarquitectura de 7 nm Ampere. Además, la compañía también anunció varios sistemas alimentados por A100 de los principales fabricantes de servidores, incluidos Asus, Dell, Cisco, Lenovo y más. El acelerador de GPU 250W A100 PCIe 4.0 es bastante similar a la variante TDP completa de 400W, y NVIDIA también promete un rendimiento casi idéntico a pesar de la caída significativa en el perfil TDP.

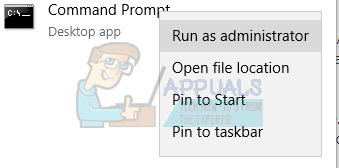

GPU NVIDIA A100 Ampere en factor de forma PCIe 4.0 con la misma configuración de GPU A100 HGX de 400 W pero a 250 W:

NVIDIA ha anunciado su acelerador de GPU PCIe 4.0 A100 PCIe. La GPU Ampere está disponible para un conjunto diverso de casos de uso industrial con sistemas que van desde una sola GPU PCIe A100 hasta servidores que utilizan dos tarjetas al mismo tiempo a través de los 12 canales NVLINK que ofrecen un total de 600 GB / s de ancho de banda de interconexión. El acelerador de GPU PCIe TDP A100 de 250 W no cambia mucho en términos de configuración del núcleo en comparación con la GPU A100 HGX de 400 W.

Este año en ISC Digital, @nvidia hizo anuncios en torno a su A100 #GPU y una nueva #AI plataforma para #supercomputación , #NVIDIA Plataforma Cyber-AI Mellanox UFM. ¡Encuentra los detalles aquí! ☺️ #Noticias tecnológicas @NVIDIADC @NVIDIAAI @mellanoxtech #AI #Lunespor la mañana https://t.co/YXrFGlTYJ0

- StorageReview.com (@storagereview) 22 de junio de 2020

La GPU GA100 tiene las especificaciones de la variante A100 HGX de 400 W con 6912 núcleos CUDA dispuestos en 108 unidades SM, 432 núcleos Tensor y 40 GB de memoria HBM2 que ofrece el mismo ancho de banda de memoria de 1,55 TB / s (redondeado a 1,6 TB / s). Sin embargo, implementar el paquete de GPU en el Estándar PCIe 4.0 tenía su propio inconveniente de reducir significativamente el TDP. Según se informa, esto significa una penalización de rendimiento del 10 al 50 por ciento según la carga de trabajo. Además, la variante TDP de 250 W de la GPU A100 es más adecuada para ráfagas cortas que para cargas sostenidas.

GPU NVIDIA A100 Ampere con factor de forma PCIe 4.0 Rendimiento:

Debido a la reducción significativa en el perfil de TDP, se podría suponer que la tarjeta presentaría relojes más bajos para compensar la menor entrada de TDP. Sin embargo, las métricas de rendimiento que ha publicado NVIDIA son realmente sorprendentes, ya que se acercan bastante a la variante TDP de 400W. El rendimiento de FP64 todavía se califica en 9.7 / 19.5 TFLOPs, el rendimiento de FP32 se califica en 19.5 / 156/312 TFLOPs (Sparsity), el rendimiento de FP16 se califica en 312/624 TFLOPs (Sparsity) e INT8 se califica en 624/1248 TOPs ( Escasa).

[PR] GIGABYTE presenta una amplia gama de servidores de la serie G con tecnología NVIDIA A100 PCIe https://t.co/Jxjrjzpl0F pic.twitter.com/Lr5KNvhx09

- TechPowerUp (@TechPowerUp) 22 de junio de 2020

La matemática simple indica, y NVIDIA asegura, que la GPU PCIe 4.0 250W A100 basada en Ampere puede ofrecer el 90 por ciento del rendimiento de la tarjeta A100 HGX (400W) en aplicaciones de servidor superiores. Esto se justifica porque la nueva variante tarda menos tiempo en completar las tareas mencionadas anteriormente. Sin embargo, los números deben ser válidos solo para intervalos cortos. En situaciones complejas que requieren capacidades de GPU sostenidas, la GPU PCIe 4.0 de 250 W puede ofrecer desde un 90 por ciento hasta un 50 por ciento del rendimiento de la GPU A100 HGX de 400 W.

Supermicro amplía la cartera de sistemas de GPU líder en la industria con soporte completo para los nuevos @NVIDIA GPU A100 PCI-E en más de una docena de sistemas.

Aprende más: https://t.co/K8g41s7sKv #NVIDIA #Supermicro # A100 #AI #HPC #GPU @NVIDIADC pic.twitter.com/9og6gfdrlw

- Supermicro (@Supermicro_SMCI) 22 de junio de 2020

La microarquitectura Ampere seguramente beneficiará al nuevo A100. NVIDIA promete al menos un aumento de rendimiento 20 veces mayor que el predecesor basado en Volta. La GPU PCIe 4.0 A100 cuenta con tecnología de GPU de instancias múltiples. Esto significa que un solo A100 se puede dividir en hasta siete GPU separadas para manejar diferentes tareas informáticas. Si bien esto aumenta la segmentación, existe NVLink de tercera generación, que permite unir varias GPU en una GPU gigante.

Etiquetas nvidia