Búsqueda por voz de Google

Google es uno de los pioneros en la investigación de la IA y una multitud de sus proyectos han llegado a llamar la atención. AlphaZero de Google Mente profunda team fue un gran avance en la investigación de IA, debido a la capacidad del programa para aprender juegos complicados por sí mismo (sin entrenamiento e intervención humanos). Google también ha realizado un excelente trabajo en Programas de procesamiento de lenguaje natural (PNL), que es una de las razones detrás de la eficiencia del Asistente de Google para comprender y procesar el habla humana.

Google anunció recientemente el lanzamiento de tres nuevos USE módulos multilingües y proporcionar modelos más multilingües para recuperar texto semánticamente similar.

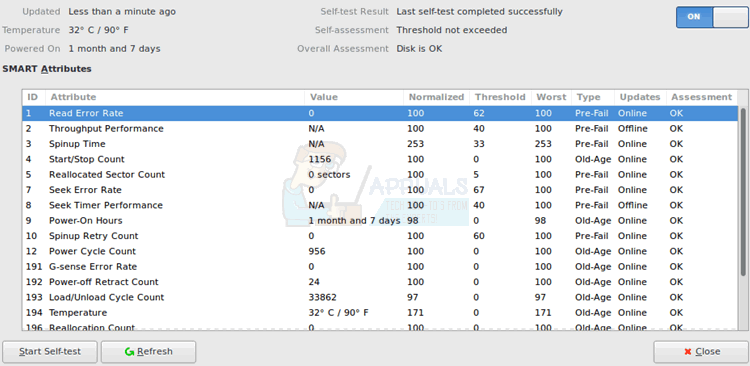

Los dos primeros módulos proporcionan modelos multilingües para recuperar texto semánticamente similar, uno optimizado para el rendimiento de recuperación y el otro para la velocidad y menor uso de memoria. El tercer modelo está especializado para recuperación de preguntas y respuestas en dieciséis idiomas (USE-QA) y representa una aplicación completamente nueva de USE. Los tres módulos multilingües se capacitan utilizando un marco de codificador dual multitarea , similar al modelo USE original para inglés, pero utilizando técnicas que desarrollamos para mejorar la Encoder dual con enfoque softmax de margen aditivo . Están diseñados no solo para mantener un buen rendimiento en el aprendizaje por transferencia, sino también para realizar bien las tareas de recuperación semántica.

El procesamiento del lenguaje en los sistemas ha recorrido un largo camino, desde el análisis sintáctico básico del árbol hasta los modelos de asociación de grandes vectores. La comprensión del contexto en el texto es uno de los mayores problemas en el campo NLP y el Codificador de oración universal lo resuelve convirtiendo el texto en vectores de alta dimensión, lo que facilita la clasificación y la denotación del texto.

Fuente de la estructura de marcado de UTE - Blog de Google

Según Google, ' Los tres nuevos módulos se basan en una arquitectura de recuperación semántica, que normalmente divide la codificación de preguntas y respuestas en redes neuronales separadas, lo que hace posible buscar entre miles de millones de respuestas potenciales en milisegundos. ”En otras palabras, esto ayuda a indexar mejor los datos.

“ Los tres módulos multilingües se capacitan utilizando un marco de codificador dual multitarea , similar al modelo USE original para inglés, pero utilizando técnicas que desarrollamos para mejorar la Encoder dual con enfoque softmax de margen aditivo . Están diseñados no solo para mantener un buen rendimiento en el aprendizaje por transferencia, sino también para realizar bien las tareas de recuperación semántica. . ' La función Softmax se usa a menudo para ahorrar potencia computacional al exponenciar los vectores y luego dividir cada elemento por la suma del exponencial.

Arquitectura de recuperación semántica

“Los tres nuevos módulos se basan en arquitecturas de recuperación semántica, que normalmente dividen la codificación de preguntas y respuestas en redes neuronales separadas, lo que hace posible buscar entre miles de millones de respuestas potenciales en milisegundos. La clave para usar codificadores duales para una recuperación semántica eficiente es precodificar todas las respuestas candidatas a las consultas de entrada esperadas y almacenarlas en una base de datos de vectores optimizada para resolver el problema. problema del vecino más cercano , lo que permite buscar rápidamente un gran número de candidatos con buenos precisión y recuerdo .”

Puede descargar estos módulos de TensorFlow Hub. Para obtener más información, consulte el completo entrada en el blog .

Etiquetas google